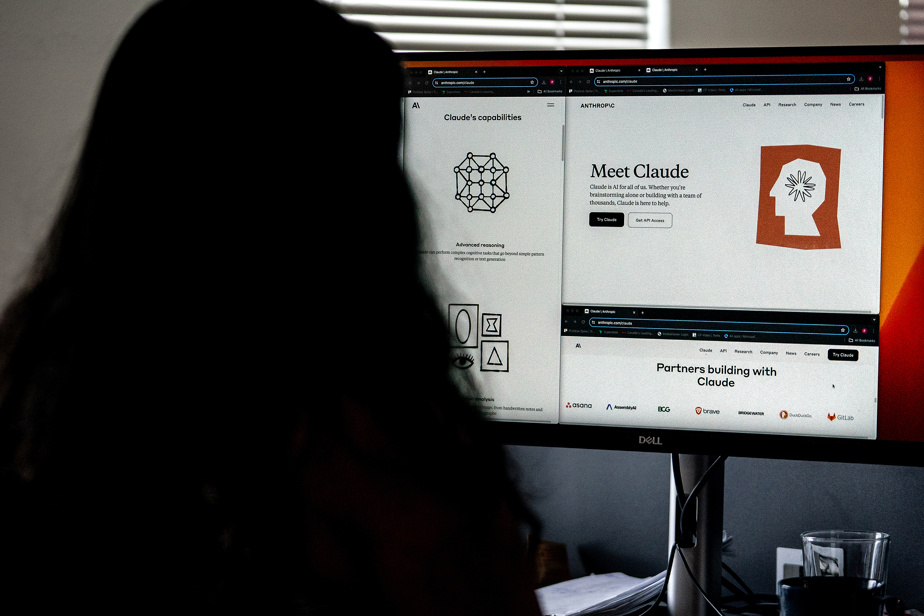

El chatbot de inteligencia artificial (IA) Claude, uno de los más populares del sector tecnológico, llegó a Canadá con la esperanza de difundir su filosofía centrada en la seguridad.

Claude, que puede responder preguntas, resumir documentos, escribir textos e incluso codificar, estuvo disponible en Canadá el miércoles. La tecnología lanzada por la empresa emergente Anthropic, con sede en San Francisco, en 2023, ya estaba disponible en más de cien países.

Ahora está cruzando la frontera porque la compañía ha visto señales de que los canadienses están ansiosos por ingresar a la IA, dijo Jack Clark, uno de los cofundadores de Anthropic y jefe de políticas de la compañía.

«Tenemos un gran interés por parte de los canadienses en esta tecnología y hemos ampliado nuestros productos y nuestras organizaciones de manera que cumplan con las normas, por lo que podemos operar en otras regiones», dijo.

La empresa hizo que su política de privacidad fuera más clara y fácil de entender antes del lanzamiento de Claude en Canadá.

Aunque Canadá ha tenido acceso a muchos de los productos de inteligencia artificial más importantes, algunos chatbots han tardado más en llegar al país.

Google, por ejemplo, introdujo su chatbot Gemini en Canadá recién en febrero porque estaba negociando con el gobierno federal una ley que le exigía compensar a las empresas de medios canadienses por el contenido publicado o reutilizado en sus plataformas.

A pesar de los retrasos, los canadienses han probado numerosos sistemas de inteligencia artificial, incluidos Copilot de Microsoft y ChatGPT de OpenAI, que provocaron el reciente frenesí de la inteligencia artificial cuando se lanzó en noviembre de 2022.

Los fundadores de Anthropic se conocieron en OpenAI, pero construyeron su propia empresa antes del debut de ChatGPT y rápidamente decidieron que su misión era hacer que Claude fuera lo más seguro posible.

«Siempre hemos pensado en la seguridad como algo que durante muchos años se consideró un complemento o una especie de misión secundaria de la IA», afirmó Jack Clark.

“Pero nuestra apuesta en Anthropic es que si hacemos de eso el núcleo del producto, crearemos un producto más útil y valioso para las personas, pero también más seguro. »

Como parte de esta misión, Anthropic no entrena sus modelos con datos de usuario de forma predeterminada. En su lugar, utiliza información disponible públicamente en Internet, conjuntos de datos cortesía de empresas de terceros y datos proporcionados por los usuarios.

También se basa en la llamada IA »constitucional», es decir, que se da un conjunto de valores a los sistemas de IA de la empresa, que pueden entrenarse para ser más útiles y menos dañinos.

En Anthropic, estos valores incluyen la Declaración Universal de Derechos Humanos de las Naciones Unidas, que enfatiza el trato equitativo de las personas sin importar edad, género, religión y color.

Los rivales de Anthropic están tomando nota, según Clark.

“Cada vez que ganamos clientes –y en parte es por la seguridad– otras empresas le prestan mucha atención y acaban desarrollando productos similares, lo que creo que es un buen incentivo para todos en el sector”, afirmó.

Espera que esta tendencia continúe.

“Nuestra opinión general es que la seguridad de la IA será un poco como los cinturones de seguridad de los automóviles y que si se desarrollan tecnologías que sean lo suficientemente simples y buenas, eventualmente todos las adoptarán porque no son buenas ideas. »

Canadá presentó un proyecto de ley centrado en la IA en 2022, pero no se implementará hasta 2025. Mientras tanto, el país ha creado un código de conducta voluntario.

El código requiere que firmantes como Cohere, OpenText y BlackBerry monitoreen los sistemas de inteligencia artificial en busca de riesgos y prueben los sesgos antes de lanzarlos.

Jack Clark no se ha comprometido a que Anthropic firme el código. Il a déclaré que l’entreprise se concentrait sur des efforts mondiaux ou du moins concernant plusieurs pays, comme le processus d’IA d’Hiroshima, que les pays du G7 ont utilisé pour produire un cadre destiné à promouvoir une IA sûre, sécurisée et digno de confianza.